A finales de octubre, tuvieron lugar dos eventos importantes en el Parque de Investigación Biomédica de Barcelona (PRBB), centrados en la intersección entre la inteligencia artificial (IA), la ética y las buenas prácticas. Estos eventos reunieron a destacados expertos, responsables de políticas y personal investigador para examinar críticamente cómo la IA está moldeando el futuro de la investigación científica y qué pautas éticas deberían guiar su uso.

Los dos eventos, cada uno con su propio enfoque, tenían como objetivo abordar los desafíos éticos de la IA en la investigación, proporcionar información sobre las normativas actuales de la UE y reflexionar sobre un enfoque responsable para la integración de herramientas de IA en el trabajo científico.

Además, el primer episodio de la nueva serie de pódcast del PRBB, “Science with a view”, también se centró en la IA en la investigación y en el uso que la comunidad hace de estas herramientas (puedes escucharlo aquí).

«Inteligencia Artificial y ética, la gran ola»

El primero de estos eventos, celebrado el 30 de octubre, fue la reunión anual de ERION-EARMA, co-organizada con el Instituto de Salud Global de Barcelona (ISGlobal) y el grupo de Buenas Prácticas Científicas del PRBB. El enfoque principal fue en los aspectos éticos y regulatorios de la IA en la investigación. Con un énfasis en el contexto regulador de Europa, el evento reunió a un destacado grupo de ponentes de todo el continente para discutir el equilibrio entre fomentar los avances en IA y proteger los derechos humanos y los valores sociales.

La sesión matutina estuvo abierta a todos y se centró en el desarrollo de herramientas de IA. La sesión comenzó con Dorian Karatzas, ex director del Sector de Ética e Integridad en la Investigación en la Dirección General de Investigación e Innovación de la Comisión Europea, quien reflexionó sobre lo que pueden hacer los y las gestoras de investigación para promover la ética y la integridad en la investigación de IA. A continuación, el profesor Dirk Lanzerath de la Universidad de Bonn exploró la gobernanza ética de la investigación en IA, basándose en su experiencia en el proyecto iRECS.

Mara de Sousa Freitas de la Universidade Católica Portuguesa habló sobre el trabajo del grupo CoARA-ERIP (Ética e Integridad en la Investigación en la Evaluación Responsable de Investigación para Datos e Inteligencia Artificial).

Juliana Chaves-Chaporro, de la UNESCO, abordó los desafíos sociales de equilibrar los avances en IA con los derechos humanos, especialmente en relación con grupos y regiones marginados. Presentó el primer estándar global sobre ética en IA de la UNESCO: la ‘Recomendación sobre la Ética de la Inteligencia Artificial’, adoptada en 2021, que, entre otras cosas, propone una evaluación del impacto ético para los equipos de desarrollo de IA, con preguntas como: ¿Quién es más probable que se vea afectado negativamente por este sistema de IA? ¿Qué forma tendrán estos impactos? ¿Qué se puede hacer para prevenir estos daños y se han asignado recursos para su prevención?

Lisa Häberlein, de la Red Europea de Comités de Ética en la Investigación (EUREC), abordó los desafíos éticos y regulatorios de la IA en la atención médica digital en regiones en desarrollo, como África Subsahariana. Presentó el proyecto STRATEGIC, cuyo objetivo es desarrollar materiales de formación adaptados para evaluaciones éticas y regulatorias en este contexto, con especial atención a la privacidad del paciente y la seguridad de los datos, el consentimiento informado – especialmente con lenguas diversas – y la mitigación de prejuicios y sesgos para garantizar una prestación sanitaria equitativa.

A continuación, Kaisar Kushibar presentó las guías FUTURE-AI para una inteligencia artificial confiable y aplicable en el ámbito sanitario, generadas por una comunidad internacional con personas expertas en ciencia de datos, clínica, ética, ciencias sociales y legislación. Mostró cómo, a pesar de las promesas de la IA en la atención sanitaria, la gran mayoría del personal médico no la utiliza debido a preocupaciones sobre la (falta de) robustez, equidad, seguridad y transparencia de las herramientas. Por lo tanto, estas guías buscan orientar sobre cómo deben diseñarse, desarrollarse y validarse las herramientas de IA médica para ser Justas, Universales, Rastreables, Usables, Robusta y Explicables (de aquí las iniciales en inglés FUTURE). A través del consenso, se definieron 30 buenas prácticas, abordando las dimensiones técnica, clínica, socioética y legal de una IA confiable. Kushibar destacó la importancia de involucrar a todas las partes interesadas para eliminar los prejuicios y ayudar a identificar las fuentes de sesgos y riesgos éticos en cada contexto y así evitar sorpresas inesperadas.

Varios de los ponentes destacaron la necesidad de involucrar a todas las partes interesadas y de trabajar en colaboración con personal investigador de diferentes disciplinas, con el fin de identificar las fuentes de sesgo y los riesgos éticos en cada contexto.

Shereen Cox, del Centro de Ética Médica de la Universidad de Oslo, Noruega, continuó con el tema de la realidad extendida, ampliando aún más la conversación sobre el impacto global de la IA y llevando los temas éticos a otra dimensión – o a otra realidad.

El tema del sesgo de género y sexo en la Inteligencia Artificial para la salud fue discutido por Atia Cortés, del Centro de Supercomputación de Barcelona (BSC) y miembra de la iniciativa Bioinfo4Women. Destacó, por un lado, la importancia de comprender las diferencias de género que son médicamente relevantes y, por otro, cómo asegurar la correcta identificación, evaluación y mitigación de los sesgos, desde el momento de la recopilación de datos, para asegurar una IA confiable.

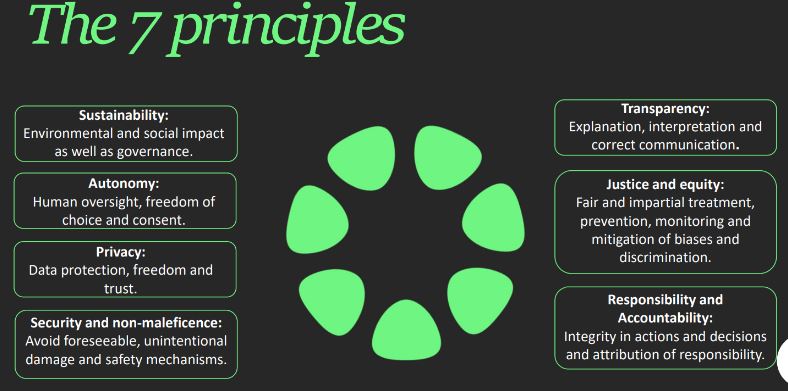

Por último, Alexandra Lillo, del Observatorio de Ética de la Inteligencia Artificial de Cataluña (OEIAC), ofreció una visión jurídica sobre el uso de la IA. Presentó su herramienta de autoevaluación «Modelo PIO», una herramienta útil tanto para desarrolladores como para usuarios, dijo. Basado en 7 principios, y con más de 130 preguntas, el Modelo PIO se basa en la normativa aplicable y en recomendaciones éticas y legales, y pretende ayudar a los usuarios a identificar si un sistema de IA cumple con los principios legales y éticos y cuál es su nivel de riesgo (probabilidad de daño).

Con la parte de la mañana terminada, el evento continuó con un almuerzo de networking y un taller por la tarde solo para miembros de ERION, donde las discusiones continuaron sobre cómo la IA y la ética pueden integrarse de manera significativa en la comunidad investigadora.

IA en la redacción científica

El segundo evento, que tuvo lugar al día siguiente, fue un curso diseñado para discutir de forma crítica el papel de la IA en la redacción científica. Este taller estaba dirigido a ayudar a los investigadores e investigadoras a comprender las normas y pautas en torno al uso de herramientas de IA en la redacción de proyectos de investigación, manuscritos, revisiones bibliográficas o solicitudes de financiación. Dirigido por Thiago Carvalho y David del Álamo Rodríguez de Fellowsherpa, el curso exploró el concepto de autoría, la responsabilidad que conlleva y por qué, por tanto, una herramienta de IA generativa como ChatGPT no puede considerarse autora de un artículo.

Los participantes debatieron las principales ventajas y usos de la tecnología generativa de IA en la investigación – en escritura, traducción, generación de imágenes o incluso revisión bibliográfica y ayuda en la lluvia de ideas. Luego, formularon sus propias mejores prácticas para el uso de IA – como nunca alimentar datos confidenciales a un algoritmo de IA o siempre verificar los resultados y referencias proporcionados – que se compararon con las pautas existentes de revistas y agencias de financiación. El mensaje principal fue que la responsabilidad última recae en el o la investigadora, cualquiera que sea la herramienta que utilice, por lo que se animó a los participantes a reflexionar críticamente sobre los riesgos potenciales de una excesiva dependencia de la IA y la importancia de mantener la integridad académica.

“La IA es, al fin y al cabo, una herramienta. Por lo tanto, depende de los investigadores e investigadoras usarla responsablemente y evitar depender excesivamente de ella.”

Caminando juntos hacia un uso responsable de la IA en la investigación

Ambos eventos subrayaron la creciente importancia de la IA en la investigación científica y la necesidad de integrar directrices éticas que aseguren que estas herramientas se usen de manera responsable.

La IA tiene el potencial de impulsar avances significativos en la investigación, pero también presenta dilemas éticos, desde la imparcialidad y la equidad hasta preocupaciones de privacidad.

En el PRBB, estamos comprometidos a fomentar un espacio donde estas conversaciones puedan tener lugar, involucrando a todas las partes interesadas, desde personal investigador hasta responsables de políticas, para que podamos avanzar colectivamente con un enfoque equilibrado y responsable, asegurando que estas herramientas transformadoras beneficien a la sociedad de maneras que sean tanto efectivas como éticas.