A finals d’octubre, dos esdeveniments significatius centrats en la intersecció entre la Intel·ligència Artificial (IA), l’ètica i les bones pràctiques van tenir lloc al Parc de Recerca Biomèdica de Barcelona (PRBB). Aquests esdeveniments van reunir destacats experts, responsables de polítiques i personal investigador per examinar críticament com la IA està donant forma al futur de la recerca científica i quines directrius ètiques haurien de guiar-ne l’ús.

Ambdós esdeveniments, cadascun amb el seu enfocament particular, tenien com a objectiu abordar els reptes ètics de la IA en la recerca, proporcionar informació sobre les normatives actuals de la UE i reflexionar sobre un enfocament responsable per integrar eines de IA en el treball científic.

A més, el primer episodi de la nova sèrie de podcasts del PRBB, “Science with a view”, també es va centrar en la IA en la recerca i en l’ús que la comunitat fa d’aquestes eines (pots escoltar-lo aquí).

“Intel·ligència Artificial i Ètica, la gran onada”

El primer d’aquests esdeveniments, celebrat el 30 d’octubre, va ser la reunió anual ERION-EARMA, organitzada en col·laboració amb l’Institut de Salut Global de Barcelona (ISGlobal) i el grup de Bones Pràctiques Científiques del PRBB. Aquest esdeveniment es va centrar en els aspectes ètics i normatius de la IA en la recerca. Amb un fort èmfasi en el marc regulador d’Europa, l’esdeveniment va reunir una impressionant llista de ponents de tot el continent per debatre l’equilibri entre fomentar els avenços en IA i protegir els drets humans i els valors socials.

La sessió del matí va estar oberta a tothom i es va centrar en el desenvolupament d’eines de IA. Va començar amb Dorian Karatzas, ex-director del Sector d’Ètica i Integritat en la Recerca de la Direcció General d’Investigació i Innovació de la Comissió Europea, que va oferir idees valuoses sobre el que els gestors i gestores de recerca poden fer per promoure l’ètica i la integritat en la recerca de IA. A continuació, el professor Dirk Lanzerath de la Universitat de Bonn va explorar la governança ètica de la recerca en IA, basant-se en la seva experiència en el projecte iRECS.

La ponent Mara de Sousa Freitas, de la Universidade Católica Portuguesa, va parlar sobre la feina del grup CoARA-ERIP (Ètica i Integritat en la Recerca en la Avaluació Responsable de la Recerca per a Dades i Intel·ligència Artificial).

Juliana Chaves-Chaporro, de la UNESCO, va abordar els reptes socials d’equilibrar els avenços en IA amb els drets humans, especialment en relació amb els grups i regions marginades. Chaves-Chaporro va presentar el primer estàndard global de la UNESCO sobre ètica en IA: la “Recomanació sobre l’Ètica de la Intel·ligència Artificial”, adoptada el 2021, que, entre altres coses, proposa una avaluació de l’impacte ètic per als equips de desenvolupament de IA, plantejant preguntes com Qui té més probabilitats de veure’s afectat negativament per aquest sistema de IA? En quina forma es presentaran aquests impactes? Què es pot fer per prevenir aquests danys, i s’han assignat recursos per a la prevenció d’aquests danys?

Després d’una pausa per al cafè, Lisa Häberlein, de la Xarxa Europea de Comitès d’Ètica en Recerca (EUREC), va abordar els reptes ètics i normatius que planteja la IA en l’atenció sanitària digital en regions en desenvolupament com l’Àfrica Subsahariana. Va presentar el projecte STRATEGIC, que té com a objectiu desenvolupar materials de formació adaptats per a avaluacions ètiques i normatives en aquell context, amb un enfocament en la privacitat del pacient i la seguretat de les dades, el consentiment informat – especialment en diversos idiomes – i la mitigació de biaixos per assegurar una atenció sanitària equitativa.

A continuació, Kaisar Kushibar va presentar les guies FUTURE-AI per a una intel·ligència artificial fiable i aplicable en l’àmbit sanitari, generades per una comunitat internacional d’experts i expertes en ciència de dades, clínica, ètica, ciències socials i dret. Va mostrar com, malgrat les promeses de la IA en l’atenció sanitària, la gran majoria del personal mèdic no la utilitza per preocupacions sobre la (falta de) robustesa, equitat, seguretat i transparència de les eines. Per tant, aquestes guies busquen orientar sobre com han de dissenyar-se, desenvolupar-se i validar-se les eines de IA mèdica per ser Justes, Universals, Rastreables, Usables, Robustes i Explicables (d’aquí les sigles en anglès FUTURE). A través del consens, es van definir 30 bones pràctiques, abordant les dimensions tècnica, clínica, socioètica i legal d’una IA fiable. Kushibar va destacar la importància d’involucrar totes les parts interessades per eliminar els prejudicis i ajudar a identificar les fonts de biaixos i riscos ètics en cada context i així evitar sorpreses inesperades.

Diversos dels ponents van destacar la necessitat d’involucrar totes les parts interessades i de treballar en col·laboració amb investigadors i investigadores de diferents disciplines, amb la finalitat d’identificar les fonts de biaixos i els riscos ètics en cada context.

Shereen Cox, del Centre d’Ètica Mèdica de la Universitat d’Oslo, Noruega, va continuar amb el tema de la realitat estesa (extended reality), ampliant encara més la conversa sobre l’impacte global de la IA i portant els temes ètics a una altra dimensió – o a una altra realitat.

El tema del biaix de gènere i sexe en la Intel·ligència Artificial per a la salut va ser discutit per Atia Cortés, del Centre de Supercomputació de Barcelona (BSC) i membre de la iniciativa Bioinfo4Women. Va destacar, per una banda, la importància de comprendre les diferències de gènere que són mèdicament rellevants i, per l’altra, com assegurar la correcta identificació, avaluació i mitigació dels biaixos, des del moment de la recopilació de dades, per assegurar una IA fiable.

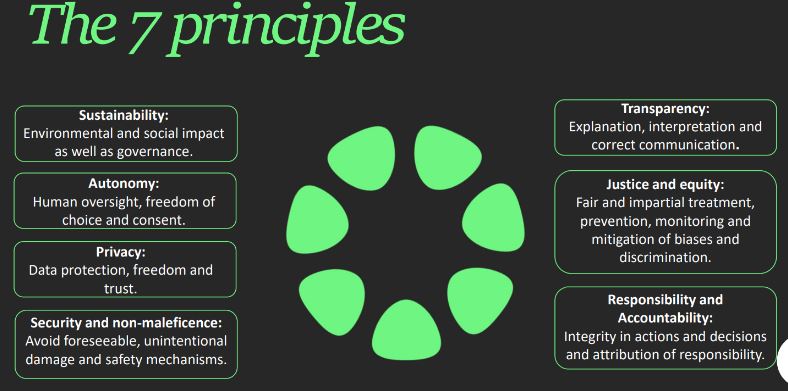

Finalment, Alexandra Lillo, de l’Observatori d’Ètica en Intel·ligència Artificial de Catalunya (OEIAC), va oferir una perspectiva legal sobre l’ús de la IA. Va presentar la seva eina d’autoavaluació, el “Model PIO”, una eina útil tant per a desenvolupadors com per a usuaris, va dir. Basat en 7 principis i amb més de 130 preguntes, el Model PIO es fonamenta en les regulacions aplicables i les recomanacions ètiques i legals, i té com a objectiu ajudar els usuaris a identificar si un sistema d’IA compleix els principis legals i ètics i quin és el seu nivell de risc (probabilitat de dany).

Amb la part del matí finalitzada, l’esdeveniment va continuar amb un dinar de networking i un taller a la tarda només per a membres de ERION, on es va debatre sobre com la IA i l’ètica poden integrar-se de manera significativa en la comunitat investigadora.

IA en la redacció científica

El segon esdeveniment, que va tenir lloc l’endemà, va ser un curs dissenyat per discutir de forma crítica el paper de la IA en la redacció científica. Aquest taller estava dirigit a ajudar els investigadors i investigadores a comprendre les normes i pautes al voltant de l’ús d’eines d’IA en la redacció de projectes de recerca, manuscrits, revisions bibliogràfiques o sol·licituds de finançament. Dirigit per Thiago Carvalho i David del Álamo Rodríguez de Fellowsherpa, el curs va explorar el concepte d’autoria, la responsabilitat que comporta i per què, per tant, una eina de IA generativa com ChatGPT no pot considerar-se autora d’un article.

Els participants van debatre les principals avantatges i usos de la tecnologia generativa de IA en la recerca – en escriptura, traducció, generació d’imatges o fins i tot revisió bibliogràfica i ajuda en la pluja d’idees. Després, van formular les seves pròpies bones pràctiques per a l’ús d’IA – com mai alimentar dades confidencials a un algoritme de IA o sempre verificar els resultats i referències proporcionades – que es van comparar amb les pautes existents de revistes i agències de finançament. El missatge principal va ser que la responsabilitat última recau en la persona investigadora, qualsevol que sigui l’eina que utilitzi, per la qual cosa es va animar a les participants a reflexionar críticament sobre els riscos potencials d’una dependència excessiva de la IA i la importància de mantenir la integritat acadèmica.

La IA és, al cap i a la fi, una eina. Per tant, depèn dels investigadors i investigadores utilitzar-la responsablement i evitar dependre’n excessivament”

Caminant conjuntament cap a un ús responsable de la IA en la recerca

Tots dos esdeveniments van destacar la creixent importància de la IA en la investigació científica i la necessitat d’integrar pautes ètiques per assegurar-ne l’ús responsable.

La IA té el potencial d’impulsar avenços significatius en la investigació, però també presenta dilemes ètics, des de la imparcialitat i l’equitat fins a preocupacions sobre la privacitat.

Al PRBB, estem compromesos a fomentar un espai on aquestes converses puguin tenir lloc, involucrant totes les parts interessades, perquè puguem avançar col·lectivament amb un enfocament equilibrat i ètic.